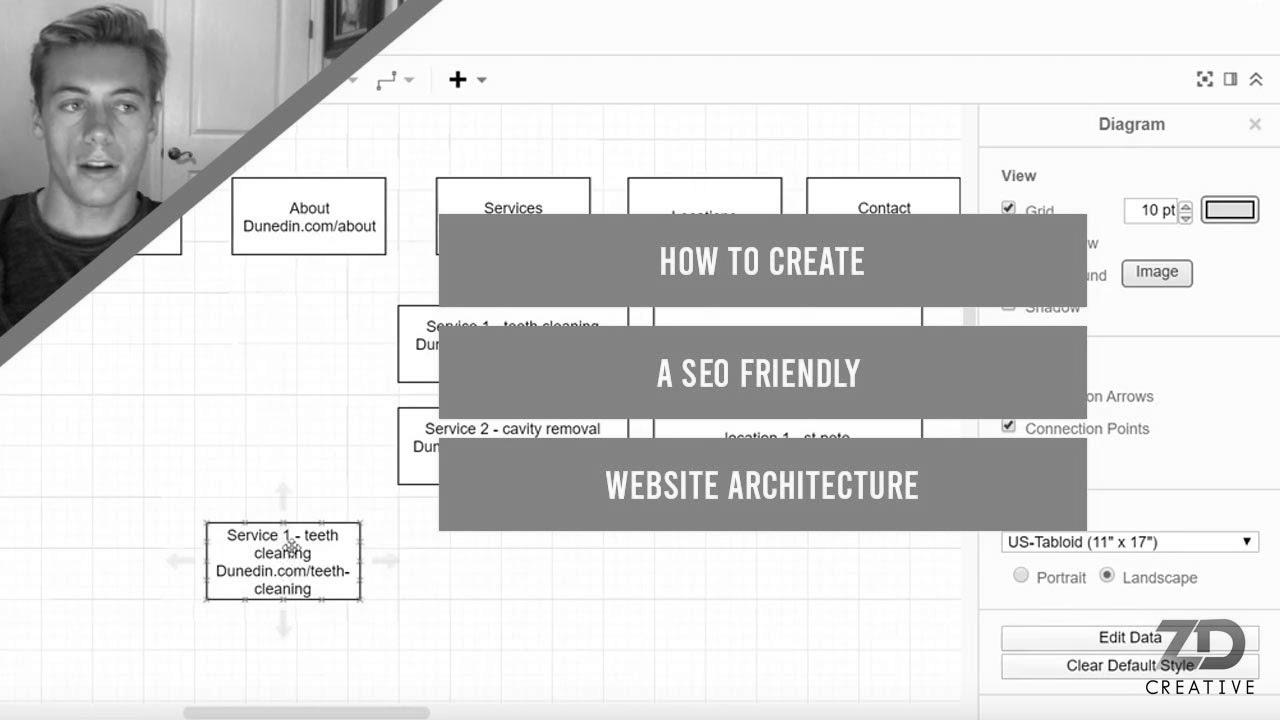

Methods to Create a search engine marketing Friendly Web site Structure For 2020

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Search engine marketing , Easy methods to Create a search engine optimisation Friendly Web site Structure For 2020 , , pk1mXSj2f6w , https://www.youtube.com/watch?v=pk1mXSj2f6w , https://i.ytimg.com/vi/pk1mXSj2f6w/hqdefault.jpg , 75 , 5.00 , Weblog Put up: https://www.zdcreative.org/seo/website-structuring/ With ClickFunnels' new One Funnel Away Problem, you'll be able to have ... , 1576644317 , 2019-12-18 05:45:17 , 00:07:00 , UC1KIxB3jC9ApHK_nBXDkgAg , ZD Creative , 1 , , [vid_tags] , https://www.youtubepp.com/watch?v=pk1mXSj2f6w , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=pk1mXSj2f6w, #Create #search engine marketing #Pleasant #Web site #Structure [publish_date]

#Create #SEO #Friendly #Web site #Architecture

Blog Put up: https://www.zdcreative.org/website positioning/website-structuring/ With ClickFunnels' new One Funnel Away Problem, you can have ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die 1. Suchmaschinen im Netz an, das frühe Web zu sortieren. Die Seitenbesitzer erkannten rasch den Wert einer bevorzugten Listung in den Suchergebnissen und recht bald fand man Anstalt, die sich auf die Verbesserung qualifizierten. In Anfängen vollzogen wurde die Aufnahme oft über die Transfer der URL der speziellen Seite in puncto divergenten Suchmaschinen im Netz. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Server der Search Engine, wo ein zweites Software, der allgemein so benannte Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu anderweitigen Seiten). Die späten Versionen der Suchalgorithmen basierten auf Infos, die mit den Webmaster eigenständig vorliegen sind, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht via Gegenstand einer Seite, aber registrierte sich bald raus, dass die Inanspruchnahme er Ratschläge nicht vertrauenswürdig war, da die Wahl der eingesetzten Schlagworte durch den Webmaster eine ungenaue Präsentation des Seiteninhalts reflektieren kann. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Webseiten bei speziellen Stöbern listen.[2] Auch versuchten Seitenersteller verschiedene Merkmale in des HTML-Codes einer Seite so zu lenken, dass die Seite stärker in den Ergebnissen aufgeführt wird.[3] Da die frühen Suchmaschinen im WWW sehr auf Merkmalen abhängig waren, die nur in den Händen der Webmaster lagen, waren sie auch sehr anfällig für Straftat und Manipulationen im Ranking. Um höhere und relevantere Testurteile in Serps zu erhalten, mussten sich die Unternhemer der Internet Suchmaschinen an diese Voraussetzungen anpassen. Weil der Erfolg einer Anlaufstelle davon anhängig ist, wesentliche Suchergebnisse zu den gestellten Suchbegriffen anzuzeigen, konnten ungünstige Resultate dazu führen, dass sich die Benützer nach sonstigen Optionen für den Bereich Suche im Web umsehen. Die Antwort der Suchmaschinen vorrat in komplexeren Algorithmen fürs Rang, die Aspekte beinhalteten, die von Webmastern nicht oder nur nicht leicht lenkbar waren. Larry Page und Sergey Brin entwickelten mit „Backrub“ – dem Stammvater von Yahoo search – eine Suchmaschine, die auf einem mathematischen Suchsystem basierte, der mit Hilfe der Verlinkungsstruktur Unterseiten gewichtete und dies in Rankingalgorithmus eingehen ließ. Auch zusätzliche Suchmaschinen bedeckt bei Folgezeit die Verlinkungsstruktur bspw. als der Linkpopularität in ihre Algorithmen mit ein. Suchmaschinen