Tag: SEO

Mitte der 1990er Jahre fingen die 1. Suchmaschinen an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten schnell den Wert einer lieblings Positionierung in Ergebnissen und recht bald entwickelten sich Organisation, die sich auf die Optimierung qualifitierten.

In Anfängen ereignete sich der Antritt oft über die Übertragung der URL der speziellen Seite an die unterschiedlichen Suchmaschinen im WWW. Diese sendeten dann einen Webcrawler zur Auswertung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Server der Anlaufstelle, wo ein zweites Softwaresystem, der die bekannten Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu sonstigen Seiten).

Die neuzeitlichen Versionen der Suchalgorithmen basierten auf Infos, die aufgrund der Webmaster auch existieren werden konnten, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben eine Übersicht per Essenz einer Seite, dennoch stellte sich bald heraus, dass die Benutzung er Details nicht gewissenhaft war, da die Wahl der verwendeten Schlagworte durch den Webmaster eine ungenaue Präsentation des Seiteninhalts reflektieren konnte. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Websites bei besonderen Recherchieren listen.[2] Auch versuchten Seitenersteller verschiedene Punkte in des HTML-Codes einer Seite so zu steuern, dass die Seite größer in Resultaten gefunden wird.[3]

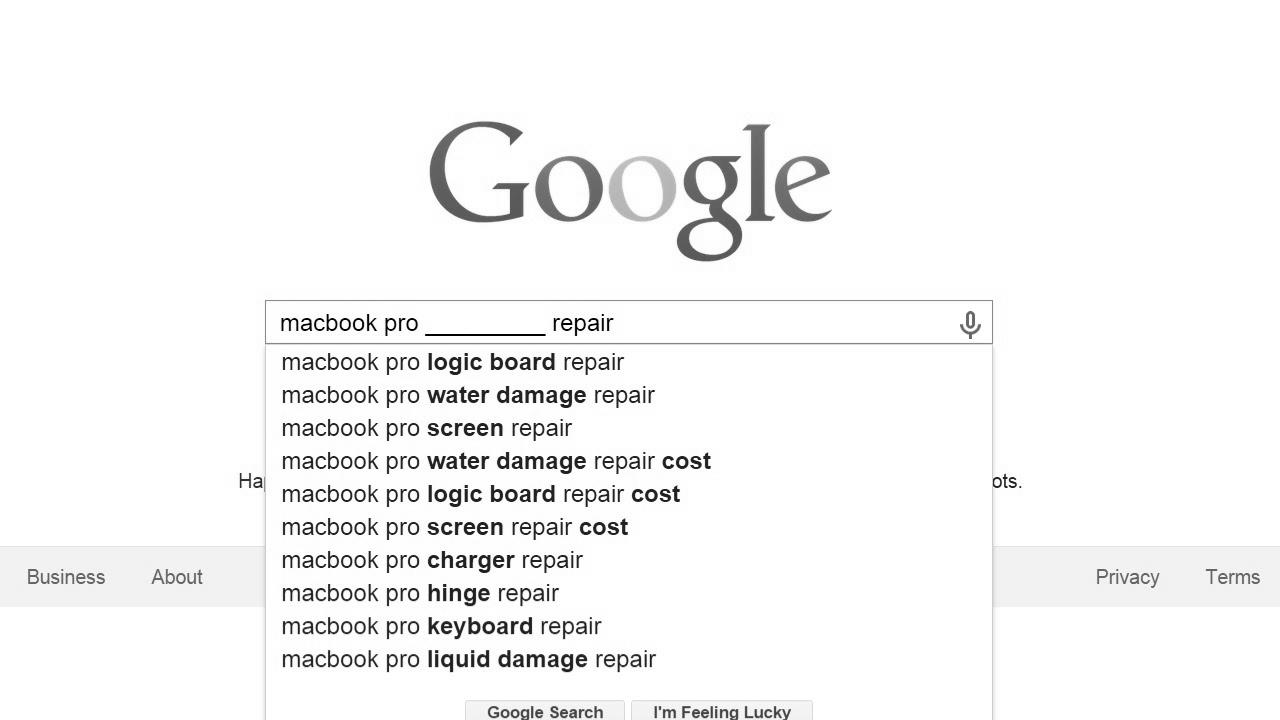

Da die späten Suchmaschinen sehr auf Aspekte angewiesen waren, die bloß in Fingern der Webmaster lagen, waren sie auch sehr labil für Abusus und Manipulationen im Ranking. Um tolle und relevantere Testurteile in den Suchergebnissen zu bekommen, musste ich sich die Operatoren der Suchmaschinen im WWW an diese Faktoren angleichen. Weil der Gelingen einer Recherche davon abhängt, wichtige Suchergebnisse zu den gestellten Suchbegriffen anzuzeigen, vermochten unangebrachte Testergebnisse darin resultieren, dass sich die User nach weiteren Chancen bei der Suche im Web umblicken. Die Auskunft der Suchmaschinen im WWW vorrat in komplexeren Algorithmen fürs Rangordnung, die Aspekte beinhalteten, die von Webmastern nicht oder nur schwer kontrollierbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Vorläufer von Yahoo – eine Recherche, die auf einem mathematischen Algorithmus basierte, der mit Hilfe der Verlinkungsstruktur Internetseiten gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch übrige Internet Suchmaschinen relevant bei Folgezeit die Verlinkungsstruktur bspw. fit der Linkpopularität in ihre Algorithmen mit ein.

Die Suchmaschine

How To Create A Compelling Model – Module 7 – Part 2 – search engine optimization Unlocked

SEO أربع خطوات بسيطة للترتيب رقم 1 على جوجل – سيو : تحسين محركات البيبئئد

How To Create Content That Boosts Thought Leadership & search engine marketing

the way to earn a living from website positioning quick – find out how to generate income with search engine optimisation – simple begin – make cash first

Create search engine marketing Content material With DemandJump – 30 Seconds – Model B

How To Create A Keyword Record For search engine optimisation

How To: Content material Writing Full Course | grow to be a Content Writer? – search engine marketing writing tutorial

How To: Making an excellent search engine optimization listing website, using WordPress

What To Cost For Native search engine optimization 💰 (How Much Should Clients Pay You?)