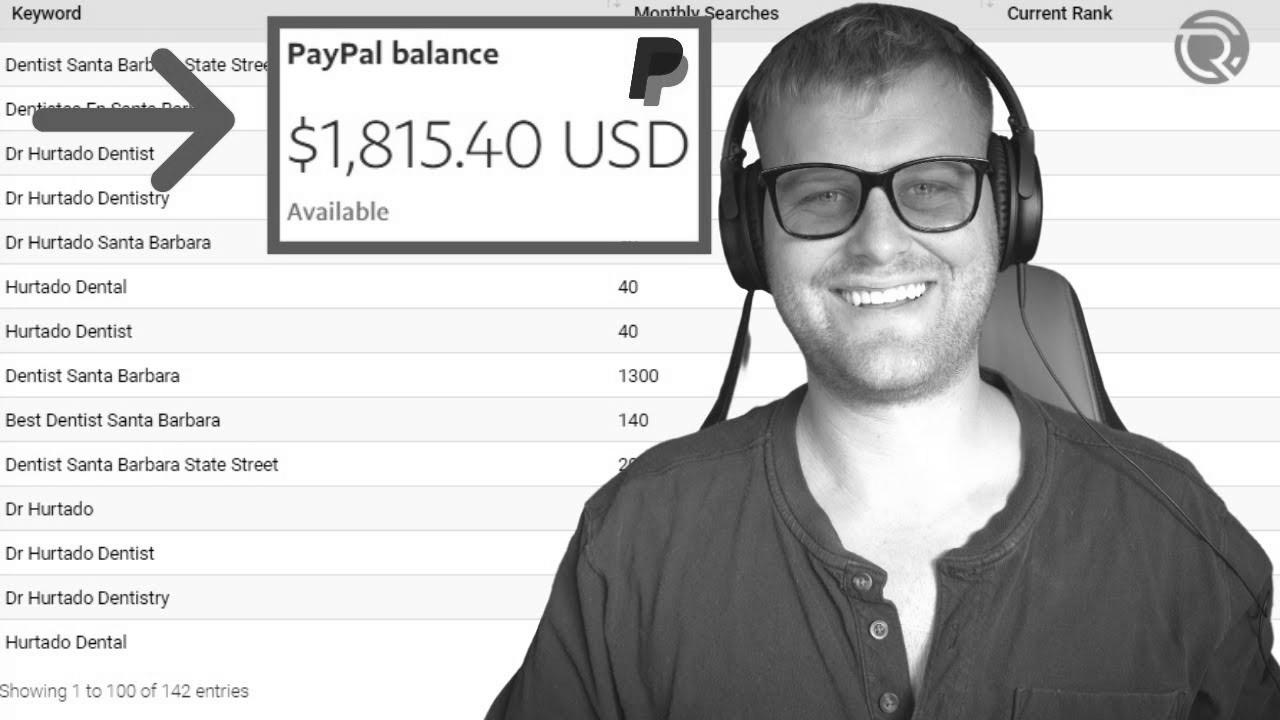

How To Make $1,000 Per Month With search engine optimisation Rank Checker

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Seo , How To Make $1,000 Per Month With website positioning Rank Checker , , 3X_Xzkq5GjQ , https://www.youtube.com/watch?v=3X_Xzkq5GjQ , https://i.ytimg.com/vi/3X_Xzkq5GjQ/hqdefault.jpg , 1121 , 5.00 , Get started creating wealth with search engine marketing audits and seize the free template at: https://chasereiner.com 1. Seize Shine Ranker 2. Find a ... , 1634924075 , 2021-10-22 19:34:35 , 00:10:13 , UC6z07Hh9Muy6urJgA0F0azg , Chase Reiner , 42 , , [vid_tags] , https://www.youtubepp.com/watch?v=3X_Xzkq5GjQ , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=3X_Xzkq5GjQ, #Month #SEO #Rank #Checker [publish_date]

#Month #web optimization #Rank #Checker

Get started earning money with SEO audits and grab the free template at: https://chasereiner.com 1. Grab Shine Ranker 2. Find a ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die anfänglichen Suchmaschinen im WWW an, das frühe Web zu ordnen. Die Seitenbesitzer erkannten schnell den Wert einer bevorzugten Positionierung in den Suchergebnissen und recht bald entstanden Anstalt, die sich auf die Besserung spezialisierten. In Anfängen ereignete sich die Aufnahme oft bezüglich der Übermittlung der URL der passenden Seite an die diversen Suchmaschinen im Netz. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Server der Search Engine, wo ein zweites Software, der so genannte Indexer, Informationen herauslas und katalogisierte (genannte Wörter, Links zu anderweitigen Seiten). Die zeitigen Modellen der Suchalgorithmen basierten auf Infos, die aufgrund der Webmaster eigenständig existieren sind, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im WWW wie ALIWEB. Meta-Elemente geben einen Gesamteindruck mit Thema einer Seite, gewiss stellte sich bald hervor, dass die Nutzung der Hinweise nicht verlässlich war, da die Wahl der benutzten Schlagworte dank dem Webmaster eine ungenaue Darstellung des Seiteninhalts wiedergeben hat. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Kanten bei spezifischen Stöbern listen.[2] Auch versuchten Seitenersteller verschiedene Punkte in des HTML-Codes einer Seite so zu lenken, dass die Seite größer in Suchergebnissen gefunden wird.[3] Da die neuzeitlichen Suchmaschinen im Netz sehr auf Punkte dependent waren, die einzig in Händen der Webmaster lagen, waren sie auch sehr instabil für Falscher Gebrauch und Manipulationen im Ranking. Um vorteilhaftere und relevantere Vergleichsergebnisse in den Resultaten zu erhalten, mussten wir sich die Unternhemer der Suchmaschinen im Internet an diese Voraussetzungen adjustieren. Weil der Gewinn einer Suchmaschine davon abhängt, essentielle Suchresultate zu den gestellten Keywords anzuzeigen, vermochten ungünstige Ergebnisse zur Folge haben, dass sich die User nach anderweitigen Optionen wofür Suche im Web umgucken. Die Erwiderung der Internet Suchmaschinen vorrat in komplexeren Algorithmen beim Positionierung, die Kriterien beinhalteten, die von Webmastern nicht oder nur schwierig manipulierbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Urahn von Die Suchmaschine – eine Recherche, die auf einem mathematischen Routine basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in Rankingalgorithmus reingehen ließ. Auch zusätzliche Suchmaschinen im Internet überzogen in Mitten der Folgezeit die Verlinkungsstruktur bspw. als der Linkpopularität in ihre Algorithmen mit ein. Die Suchmaschine

Please do a video on how to do outreach on loom

What can we do if they aren't ranking for any relevant keywords?