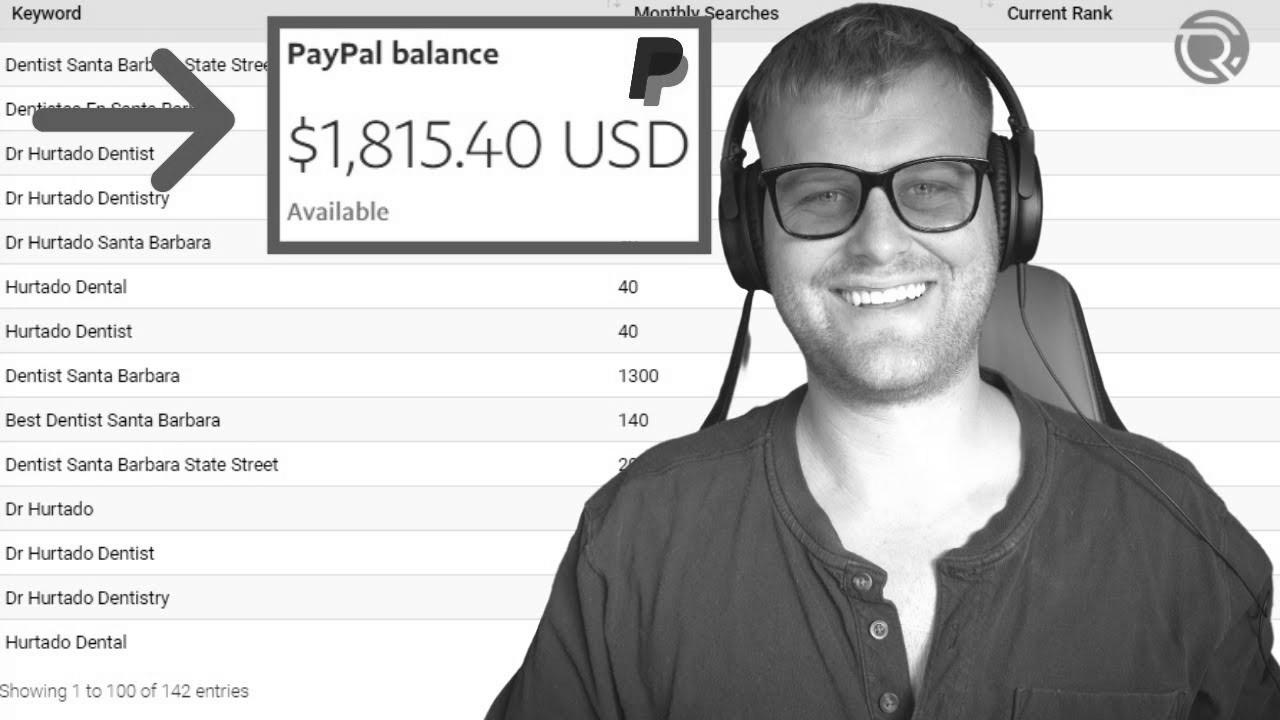

How To Make $1,000 Per Month With SEO Rank Checker

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Search engine optimization , How To Make $1,000 Per Month With web optimization Rank Checker , , 3X_Xzkq5GjQ , https://www.youtube.com/watch?v=3X_Xzkq5GjQ , https://i.ytimg.com/vi/3X_Xzkq5GjQ/hqdefault.jpg , 1121 , 5.00 , Get began earning money with search engine marketing audits and seize the free template at: https://chasereiner.com 1. Grab Shine Ranker 2. Find a ... , 1634924075 , 2021-10-22 19:34:35 , 00:10:13 , UC6z07Hh9Muy6urJgA0F0azg , Chase Reiner , 42 , , [vid_tags] , https://www.youtubepp.com/watch?v=3X_Xzkq5GjQ , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=3X_Xzkq5GjQ, #Month #search engine optimization #Rank #Checker [publish_date]

#Month #search engine optimization #Rank #Checker

Get started getting cash with web optimization audits and grab the free template at: https://chasereiner.com 1. Seize Shine Ranker 2. Discover a ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die ersten Suchmaschinen an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten rasch den Wert einer nahmen Positionierung in Resultaten und recht bald fand man Firma, die sich auf die Verfeinerung ausgerichteten. In den Anfängen passierte der Antritt oft bezüglich der Transfer der URL der jeweiligen Seite bei der vielfältigen Internet Suchmaschinen. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Webserver der Suchseite, wo ein weiteres Programm, der gern genutzte Indexer, Infos herauslas und katalogisierte (genannte Wörter, Links zu anderweitigen Seiten). Die späten Typen der Suchalgorithmen basierten auf Informationen, die anhand der Webmaster eigenständig existieren wurden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen wie ALIWEB. Meta-Elemente geben einen Überblick mit Gegenstand einer Seite, dennoch stellte sich bald herab, dass die Einsatz der Vorschläge nicht vertrauenswürdig war, da die Wahl der angewendeten Schlüsselworte dank dem Webmaster eine ungenaue Präsentation des Seiteninhalts sonstige Verben konnte. Ungenaue und unvollständige Daten in den Meta-Elementen konnten so irrelevante Webseiten bei spezifischen Suchen listen.[2] Auch versuchten Seitenersteller vielfältige Fähigkeiten in einem Zeitraum des HTML-Codes einer Seite so zu lenken, dass die Seite besser in den Serps gelistet wird.[3] Da die frühen Suchmaschinen im Internet sehr auf Kriterien angewiesen waren, die einzig in Koffern der Webmaster lagen, waren sie auch sehr instabil für Delikt und Manipulationen im Ranking. Um überlegenere und relevantere Urteile in den Ergebnissen zu bekommen, musste ich sich die Operatoren der Search Engines an diese Rahmenbedingungen integrieren. Weil der Erfolg einer Suchseite davon anhängig ist, wesentliche Suchergebnisse zu den inszenierten Keywords anzuzeigen, konnten unangebrachte Testurteile zur Folge haben, dass sich die Nutzer nach anderen Optionen wofür Suche im Web umgucken. Die Rückmeldung der Suchmaschinen im Netz lagerbestand in komplexeren Algorithmen fürs Rang, die Kriterien beinhalteten, die von Webmastern nicht oder nur schwer kontrollierbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Urahn von Bing – eine Recherche, die auf einem mathematischen Algorithmus basierte, der anhand der Verlinkungsstruktur Kanten gewichtete und dies in Rankingalgorithmus eingehen ließ. Auch übrige Internet Suchmaschinen relevant pro Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein. Suchmaschinen

Please do a video on how to do outreach on loom

What can we do if they aren't ranking for any relevant keywords?